深度學習 - 學習筆記(四)

本學習筆記課程為 Coursera DeepLearning.ai 推出之深度學習專項課程,學習筆記摘要自 AI . FREE Team 讀書會,透過學習筆記讓讀者認識深度學習。(進度:Course 1/Week 4)

一、線上課程資訊

課程名稱:深度學習專項課程 (Deep Learning Specialization)

課程教授:吳恩達 教授 (Andrew Ng)

課程主題:類神經網絡與深度學習 (Neural Network and Deep Learning)

二、課程內容

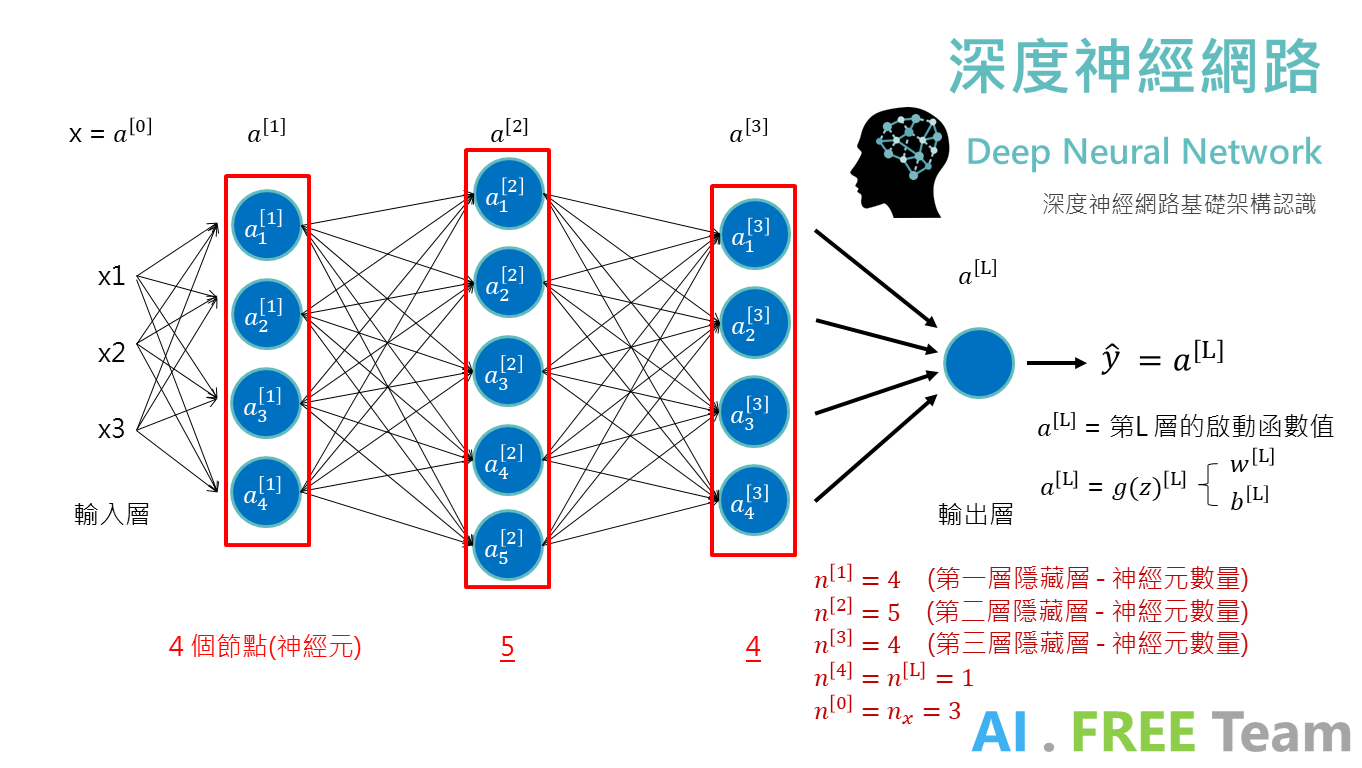

深度神經網絡(Deep Neural Network) 是由多個神經元 (Neurons)及多個隱藏層(Hidden Layer) 所組成,從上方示意圖中,每個隱藏層各自擁有的神經元以n[L]表示,而這邊需注意:輸入層不列入計算隱藏層,故為n[0]、輸出層則列入計算為隱藏層,故為n[L]。

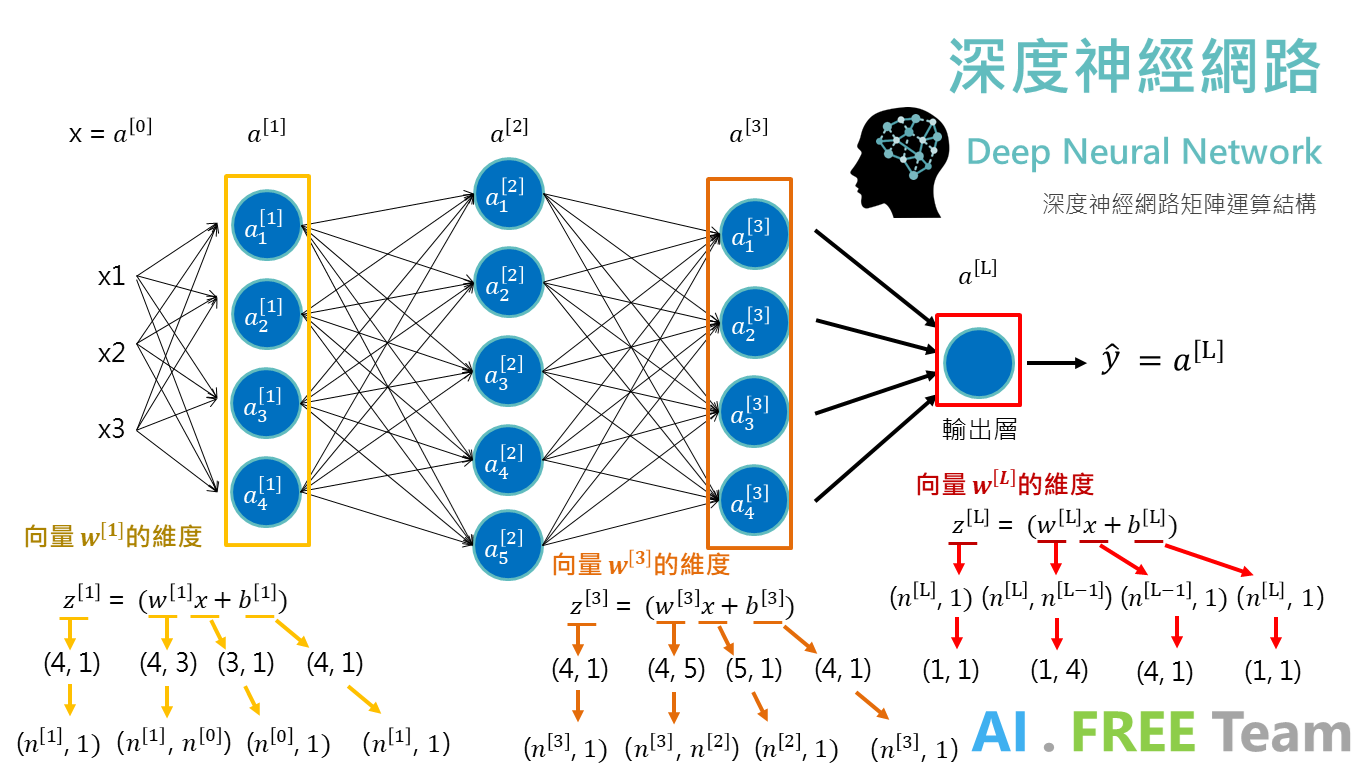

在深度神經網絡中,矩陣的維度是開發 AI 過程中相當重要的一環,以上圖各層矩陣的維度,可以觀察出矩陣大小外型的規則(如右下,矩陣大小標示)。

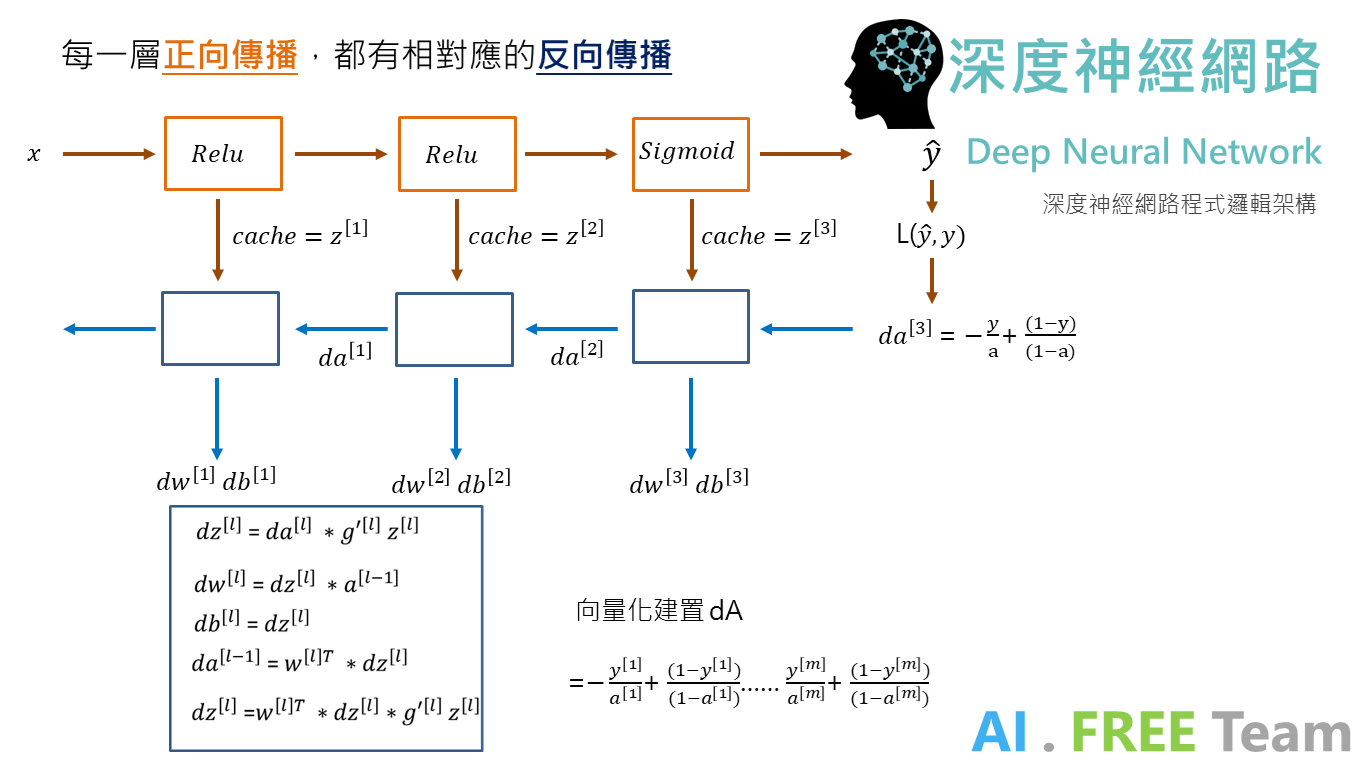

深度神經網絡運算向量化

在進行類神經網絡運算時,為提升運算過程的效率,我們以向量化的方式,將 m 個數據集的特徵值堆疊成矩陣,而在矩陣運算中維度的變化,可參考右下角規則公式與上一張做比對。(上一張圖 m = 1;代表只將一個數據丟入神經網路中)

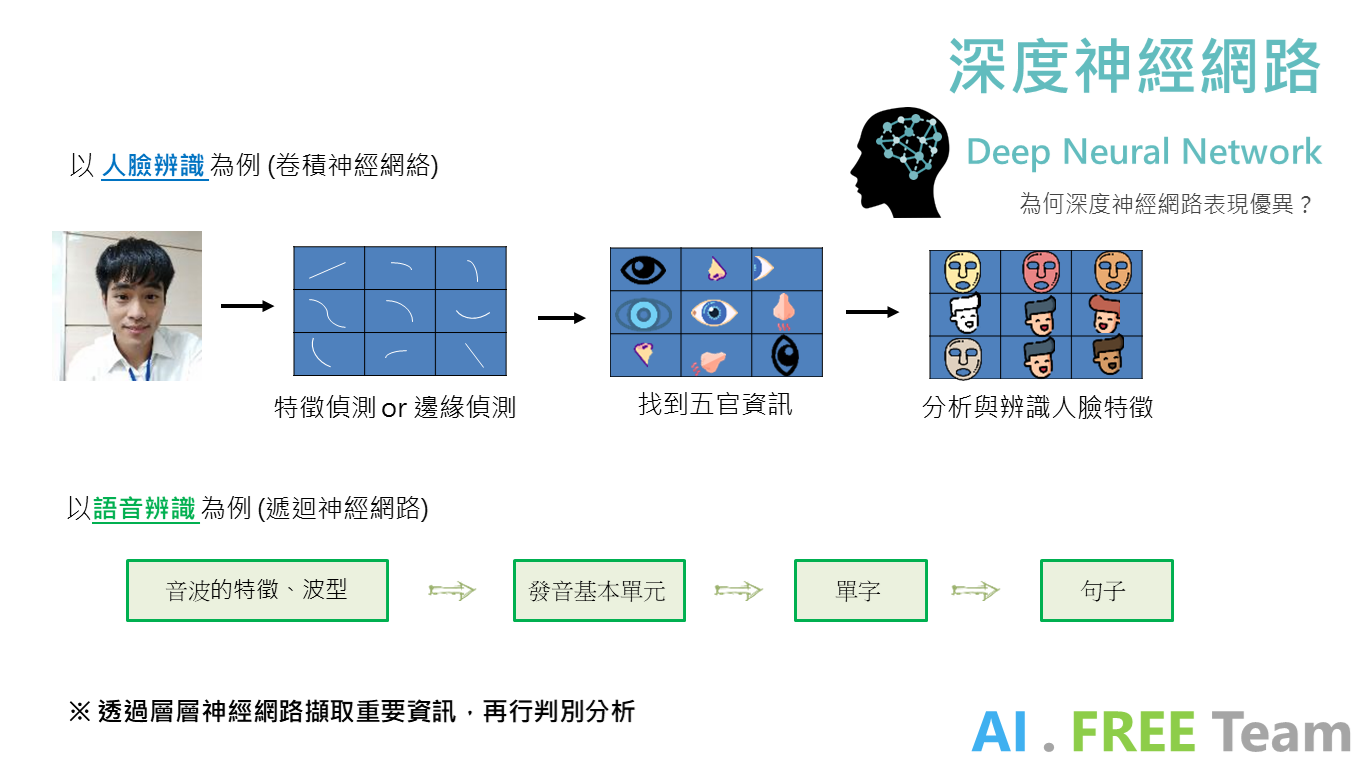

為什麼神經網路能超越傳統機器學習模型?

透過深度神經網路(多個隱藏層),能夠使類神經模型得以循序漸進處理數據、整理資料的訊息;以上圖,人臉辨識及語音辨識為例,在數據透過每一層隱藏層的過程中,神經網絡擷取並處理其重要的資訊,再傳送往下一個隱藏層;如此一來,數據中的重要資訊能在每一層傳遞中獲得保留及彙整,而數據中的雜訊則在每一層傳遞中消失。

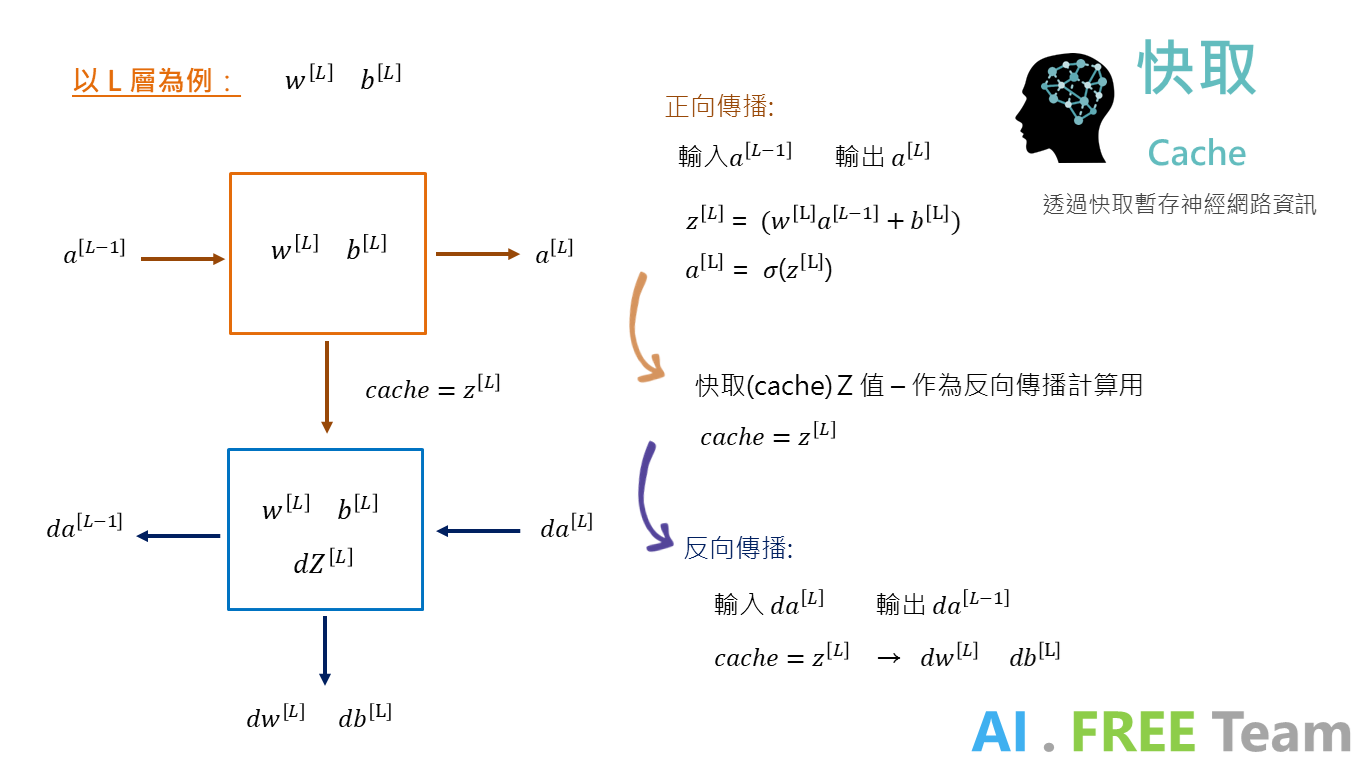

在開發 AI 模型時,資料科學家經常會使用「cache」 - 快取,來暫存向後傳播所需要數值( Z[L] )。

而在深度神經網絡的架構下,因模型巨大、層數眾多,cache 會逐一去紀錄每個隱藏層所計算出來的 Z[L] 值,以利後續層層計算向後傳播。

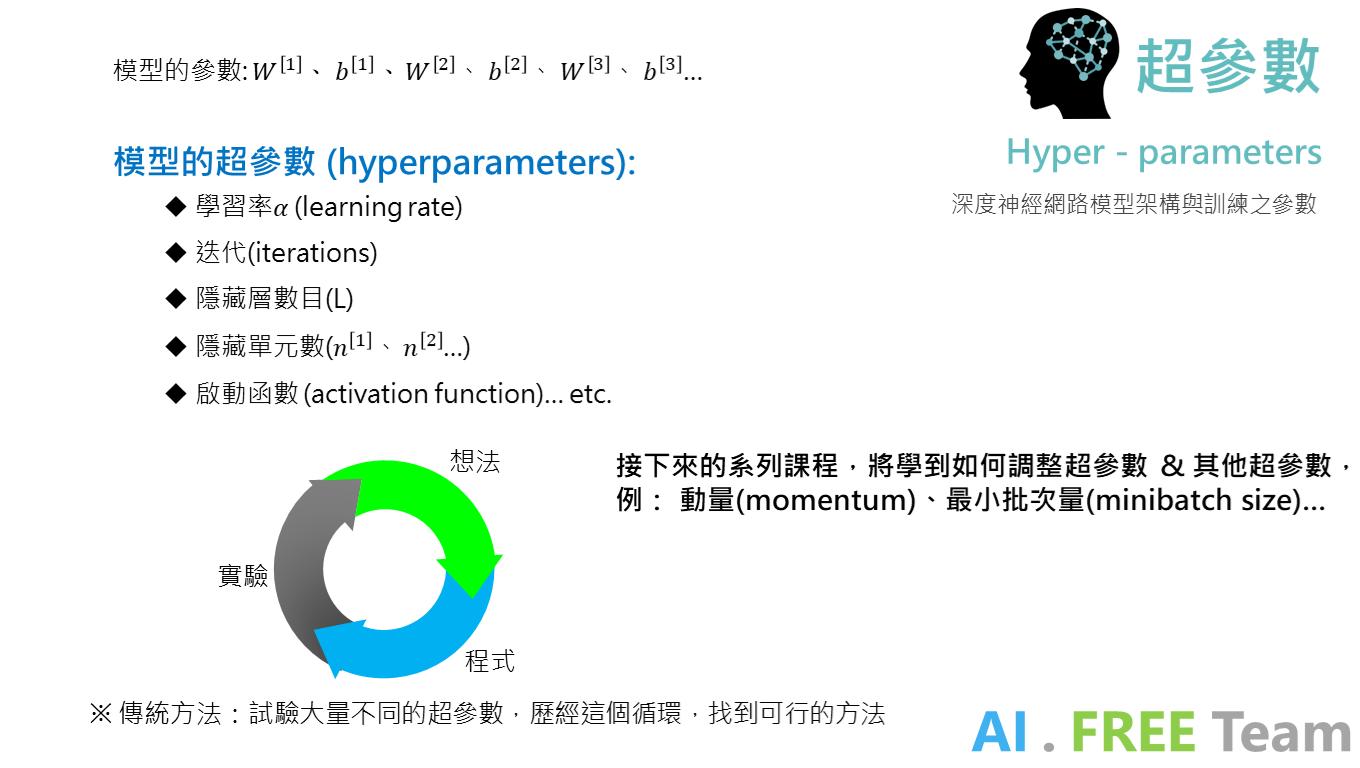

超參數

在開發神經網絡架構中,我們透過向後傳播來更新模型的參數 ( W[L], b[L] );而控制模型的大小、訓練方式、結構等參數,我們則稱之「超參數」。

在傳統的機器學習方法中,資料科學家往往都會隨機調整參數進行試驗,並反覆循環著上述流程;而下一堂課程,將鎖定如何有方法、有方向地去調整超參數,以及更多可應用的超參數介紹。

以上統整自人工智慧自由團隊 - 深度學習專項課程讀書會,歡迎未來有興趣一起參與學習的朋友們,一起追蹤我們粉絲專頁、加入學習社團,並持續關注 AI . FREE Team 部落格,如有進一步問題或是交流需求,歡迎透過粉專 or email 聯絡我們喔!(AI.Free.Team@gmail.com)

相關資訊:

認識自由團隊:https://goo.gl/D2in5A

加入學習社群:https://goo.gl/k98CBy

企業合作專區:https://goo.gl/osGHhK

自由學習平台:https://goo.gl/ALVKKF

【AI.Free Team 介紹影片】

https://www.youtube.com/watch?v=nEOi9qk35KA